イントロ

オンライン検索の半分以上はモバイル端末で行われている。しかし、多くのウェブサイトは検索結果に表示されるのに苦労している。新しいページがクロールされないと、Googleインデックスの問題に直面するかもしれません。あるいは、robots.txtがGoogleに表示させたいパスをブロックしている場合もあります。

サイトマップがなかったり、インデックスタグが有効でなかったりすると、ウェブサイトが検索から消えてしまうことがある。設定が古かったり、altテキストがなかったり、リンクが切れていたりすると、問題が発生します。次のセクションでは、これらの問題を素早く修正する方法を学びます。

インデックスの基本を理解する

自分のページを検索結果に表示させたい。しかし、それは新しいコンテンツを追加するだけではありません。優れたセットアップによって、検索ボットはあなたのサイトを素早く見つけ、問題を回避することができます。

Google Search Consoleは、あなたのサイトはユーザーとボットの両方にとってうまく機能するべきだと述べています。これにより、ユーザーが必要なものを見つけやすくなります。

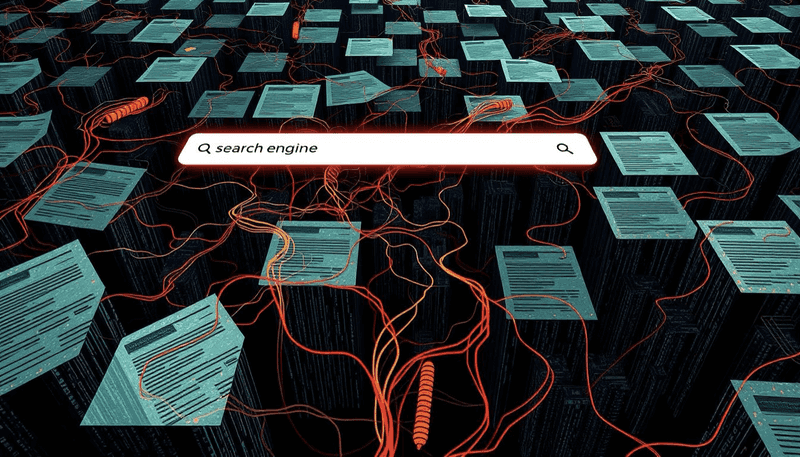

検索エンジンはリンクを見て、コンテンツをチェックし、大きなデータベースに保存します。これにより、人々が検索したときにあなたのページが表示されやすくなります。よく整理されたサイトと簡単なナビゲーションは、オンラインで目立つのに役立ちます。

検索エンジンの役割

クローラーは、ページがインデックスされるべきかどうかを確認するために、すべてのリンクをチェックします。グーグルは毎日何十億ものページを見ています。ですから、あなたのサイトをナビゲートしやすくし、うまくリンクを張りましょう。

これにより、クローラーは必要なものを見つけやすくなる。また、あなたのサイトが他のサイトとつながりやすくなります。

ウェブサイトにインデックスが重要な理由

インデックスされているページは検索に表示されやすくなります。インデックスに関する問題を解決することで、サイトがより多く見られるようになります。サイトの鮮度を保ち、モバイルフレンドリーにし、良いバックリンクを獲得しましょう。

あなたのサイトがインデックスされていない兆候

キーとなるページにオーガニック・トラフィックがない場合、それは赤信号です。レポートのインプレッションがゼロということは、検索エンジンがそれらのページをリストアップしていないことを意味します。これは通常、クローラーがあなたのサイトにアクセスできないか、読むことができないために起こりま��す。

効果的なSEOのためのオールインワン・プラットフォーム

ビジネスが成功する背景には、強力なSEOキャンペーンがあります。しかし、数え切れないほどの最適化ツールやテクニックがあるため、どこから手をつければいいのかわからないこともあります。でも、もう心配はありません。効果的なSEOのためのオールインワンプラットフォーム「Ranktracker」を紹介します。

多くの障害が道を阻むサイトマップがないと、検索エンジンはあなたのURLを見つけることができません。サイト構造が悪いと、重要なページが隠され、見えなくなってしまいます。NoindexタグやヘッダーがGooglebotをブロックし、コンテンツが表示されなくなる。これらの問題は、しばしばGoogleサーチコンソールのエラーを引き起こします。

- インデックス・カバレッジ・レポートで、"除外 "または "発見されたがインデックスされていない "と表示されているページを確認してください。

- コードに予期せぬnoindexディレクティブがないか探してください。

- 発見を助けるために適切なサイトマップを提出すること。

| インジケーター | 説明 |

| 印象が低い、またはない | クローラーがページに到達していない可能性を示すシグナル |

| クリック率ゼロ | あなたのサイトが関連するクエリから見えないことを示唆します。 |

| Googleサーチコンソールのエラー | クロールやインデックスの失敗に関する高レベルのアラートやメッセージ |

Googleインデックスに関する一般的な問題

あなたのサイトが検索結果に表示されず、困惑していませんか?301リダイレクトの設定ミスや不審なコードが、あなたのページを隠しているかもしれません。可能性のある問題を詳しく調べることで、サイトの可視性が損なわれる前に修正することができます。

クロールエラーとサーバーの応答

404エラーを引き起こすリンク切れはクローラーを動揺させる。グーグルは410ページを404のように見ている。インデックスされる問題の約40%は、サーバークラッシュやタイムアウトなどの5xxエラーです。

サーバーのログをチェックし、リダイレクトのル�ープを避け、サーバーの設定を安定させる。これらの手順は、これらの問題を回避するのに役立ちます。

不正確なカノニカルタグ

ページによっては、間違った正規URLを指している場合がある。これでは、検索エンジンは間違ったコンテンツにフォーカスしてしまう。クロールの予算を無駄にし、SERPを不完全なものにしてしまう。

正規参照が正しいことを確認しましょう。これは、検索エンジンが正しい一次バージョンを見つけるのに役立ちます。

ページ間の重複コンテンツ

複数のURLでコピーされたテキストは検索エンジンを混乱させる。インデックストラブルの約20%は、canonicalタグのない重複から発生している。ユニークな説明文を使用し、言語のバリエーションを管理し、正しいドメインにリンクすることで解決できる。

| 問題 | 考えられる影響 | 推奨される修正 |

| 404または410エラー | クローラーの信頼度を下げる | リンク切れの修復や有効なリダイレクトの実行 |

| 不正確なカノニカルタグ | 誤ったページ順位 | ターゲットURLが正確に設定されていることを確認する |

| 重複コンテンツ | インデックス信号の分割 | ユニークなテキストを使用し、正規参照を定義する |

インデックス作成におけるRobots.txtの役割

ドメインのルートにある小さなファイルが、検索エンジンの表示に大きな影響を与えることがある。Googlebotのようなクローラーに、どのページを見るべきかを指示する。設定を誤ると、検索結果から外�れてしまうなどの問題を引き起こす可能性があります。robots.txtファイルを適切に設定し、インデックスの問題を回避する方法については、こちらをご覧ください。

Robots.txtはクローラーを誘導するが、すべてをブロックするわけではない。ブロックされたページが詳細なしに表示されることもある。画像や動画は影響を受けるかもしれないが、他のサイトからのリンクでそれらを明らかにすることができる。HTTPレスポンスをチェックすることで、よりコントロールしやすくなります。

Robots.txtファイルの確認方法

robots.txtは、yourdomain.com/robots.txtで検索してください。Google Search Consoleは、検索エンジンがあなたのルールに従っているかどうかを表示することができます。WixやBloggerのようなCMSには、ファイルを編集する代わりに組み込みのコントロールがあります。

Robots.txt管理のベストプラクティス

ユーザーエージェントで適切なクローラーをターゲットにしてください。どうしても必要な場合を除き、すべてをブロックしないこと。何がインデックスされるべきかを示すためにサイトマップのリンクを追加する。ファイルを頻繁にチェックし、小さく保ち、サーバーが2xxステータスコードを表示するようにしましょう。

Robots.txtによってブロックされたページの解決

ファイルにUser-agent がある場合:*Disallow:/となって�いる場合、Googleのボットからサイト全体をブロックしています。この行を削除するか、パスを修正することで、見たいページのクロールやインデックスの問題がなくなります。URL がインデックスされているが制限されている場合、Google Search Console に "Valid with warning" というメッセージが表示されることがあります。これは、ファイルをチェックし、正しい部分のみがブロックされていることを確認する必要があることを意味します。

効果的なSEOのためのオールインワン・プラットフォーム

ビジネスが成功する背景には、強力なSEOキャンペーンがあります。しかし、数え切れないほどの最適化ツールやテクニックがあるため、どこから手をつければいいのかわからないこともあります。でも、もう心配はありません。効果的なSEOのためのオールインワンプラットフォーム「Ranktracker」を紹介します。

まず、誤って重要なコンテンツをブロックしている行を探す。WordPressのYoast SEOや Rank Mathのようなプラグインを使えば、robots.txtを直接編集することができる。Shopifyはデフォルトのファイルを変更できないので、よりコントロールするためにリバースプロキシを使っているユーザーもいる。

編集が検索結果に表示されるまでに数日かかる場合がありますので、Google Search ConsoleのIndex Coverageレポートを見てください。

ブロックされたページを修正するには、以下の手順をお試しください:

- グローバルなDisallowディレクティブを削除するか、不要なディレクトリのみを対象とする。

- Googleに再クロールしてもらうか、手動で検証してもらう。

- カバレージレポートから警告が消えるまでチェックを繰り返す。

その他のインデクセーション問題への対処

重要な部分が欠けていると、あなたのサイトは表示されないかもしれません。XMLサイトマップは、Googleが各ページを見つけるのに役立ちます。これにより、ウェブサイトがGoogleに表示されないなどの問題を解決することができます。サイトマップの欠落は低視認性の大きな原因です。

Google Search Consoleからサイトマップを送信すると、より早く検索されるようになります。これは、新しいコンテンツを頻繁に投稿する場合に非常に便利です。

孤児ページも大きな問題だ。これはリンクのないページのことです。これでは検索エンジンも訪問者も見つけにくい。

サイトの他の部分からこれらのページをリンクすることができます。これにより、重要なキーワードでのランキングを向上させることができます。また、URLがGoogleに知られていないという問題を回避することもできます。

また、付加価値のないページを削除することもできる。あるいは、サイト構造をより強固なものにするためにリンクさせることもできる。

正しいサイトマップの送信

Google Search Consoleは、サイトマップが受け入れられたかどうかを教えてくれます。重要なURLはすべて含めるようにしましょう。1日にたくさんのサイトマップを送信しないようにしましょう。

孤児ページの修正

シンプルなリンクはページを人気ページにすることができる。ホームページや人気記事から、これらの隠れたページへの簡単な経路を作りましょう。

| インデックスのシナリオ | 好転の可能性 | キーファクター |

| 新しいウェブサイト | 最長2週間 | クロールの優先順位を下げる |

| ブログ開設 | 約24時間 | 頻繁な更新 |

| 交通量の多いサイト | 時間以内 | 高いクロール予算 |

インデックス回復のための実践的ステップ

新しいコンテンツを追加し、Googleに直接相談することから始めましょう。多くのブランドは、大きな変更の後にインデックスの問題を修正することで良くなります。これにより、検索��結果でサイトが見つかりやすくなります。

ほとんどの人がモバイル端末で閲覧しています。そのため、大きな変更後は素早くページをチェックしましょう。グーグルは少なくとも1週間は待つように言っていますが、大きな変更にはもっと時間がかかるかもしれません。

古いコンテンツの更新と再出版

古い記事を新しい情報やビューで新鮮にする。そうすることで、クローラーはすぐに戻ってくるよ��うになる。タイトルを変えたり、テキストを追加したり、リンクを修正したりすることで、ページを再び活気づけることができる。

Google Search Consoleを使ったクイックフィックス

URL検査ツールを使って、Googleに更新をチェックしてもらいましょう。大きな変更やリブランディングの際に役立ちます。コンテンツが300ワード以上であることを確認し、重複ページを避けましょう。そうすることで、検索結果でサイトが上位に表示されるようになります。

継続的なメンテナンスとモニタリング

サイトの認知度を高めるために、重要な指標に目を配りましょう。Googleは、インデックスカバレッジレポートを頻繁にチェックすることを推奨しています。これは、クロールされたページのエラーや低下を発見するのに役立ちます。

警戒することで、問題が悪化する前に修正することができます。リンク切れやブロックされたページを素早く修正することで、サイトの可視性を保つことができます。このような問題を無視すると、サイトの評判を損なう可能性があります。

効果的なSEOのためのオールインワン・プラットフォーム

ビジネスが成功する背景には、強力なSEOキャンペーンがあります。しかし、数え切れないほどの最適化ツールやテクニックがあるため、どこから手をつければいいのかわからないこともあります。でも、もう心配はありません。効果的なSEOのためのオールインワンプラットフォーム「Ranktracker」を紹介します。

定期的なチェックで503や404の問題を見つけることができます。ダウンタイム中に正しいHTTPコードを使用することで、ランキングに貢献します。これらの問題を常に把握しておくことで、新しいチャンスに備えることができます。

結論

44の小規模サイトと18の大規模サイトの調査では、クロールエラーとソフト404ページが問題を引き起こしていた。Googlebotがリンクのないページを見つけるのは困難であった。100,000ページ以上のサイトはクロールの予算を浪費し、eコマースページに最も打撃を与えた。

robots.txt、サイトマップ、canonicalタグを修正することで、サイトの可視性を保つことができます。これにより、オーガニックトラフィックに悪影響を与える問題を防ぐことができる。Google Search Consoleでクロールエラーをチェックすることは重要です。

価値の低いページを削除することで、Googleは重要なページに集中することができます。ウェブトラフィックの約70%はオーガニック検索によるものです。サイトを常に更新し、技術的な問題をなくすことがランキングを向上させます。

サイトのパフォーマンスを観察し、問題が発生したら迅速に対処することが重要です。

よくあるご質問

グーグル・インデックスの問題とは何か?

Googleインデックスの問題は、あなたのコンテンツがGoogleのインデックスに正しく保存されていない場合に起こります。これにより、あなたのサイトはGoogleで見えなくなり、オーガニックトラフィックを逃し、視認性が損なわれる可能性があります。不適切なSEO設定、技術的な問題、インデックスの問題などが、このような問題を引き起こす可能性があります。

あなたのサイトが検索結果に表示されないのはなぜか、そして本当にインデックスされているかどうかを知るにはどうすればいいのか。

あなたのサイトがGoogleに掲載されていない場合、サイトマップの欠落やブロックされたページなど、インデックスの問題が原因かもしれません。Google Search Consoleの「インデックスカバレッジ」と「ページインデックス」レポートでサイトの状態を確認しましょう。これらのツールは、あなたの可視性に影響を与えるクロールやインデックスの問題を表示します。

Google Search Consoleを使ったインデックス異常のトラブルシューティング方法とは?

インデックスカバレッジレポートを見て、除外されているページやブロックされているページを探すことから始めましょう。クロールエラーやリンク切れを修正し、URL検査ツールでURLを再送信します。この方法は、インデックスの問題を見つけ、修正するのに役立ちます。

robots.txtは検索エンジンのインデックス作成においてどのような役割を果たすのか?

robots.txtファイルは、あなたのサイト上でボットが見ることができるものを制御します。重要なページがブロックされていると、検索エンジンはそのページをクロールできません。定期的にrobots.txtをチェックしてテ��ストし、ミスを防ぎましょう。

404エラーや5xxエラーに起因するクロールやインデックスの問題を解決するには?

まず、エラーの原因となっているURLを見つけて修正します。リンク切れや古いページかもしれません。リンクを更新するか、サーバーの問題を修正するか、リダイレクトを使用する。その後、適切にインデックスさせるために再送信するか、再クロールをリクエストする。

孤児ページや壊れたサイトマップを処理する最善の方法は?

リンクのないページは見逃される可能性があります。リンクを追加するか、有用でなければ削除する。サイトマップが壊れている場合は、有効なURLでファイルを更新し、Google Search Consoleから再送信する。

長期にわたって健全なインデックスを維持するには?

定期的にサイトをチェックしましょう。重複コンテンツ、古いURL、Google Search Consoleのエラーなどをチェックしましょう。インデックスの問題を避けるために、コンテンツを更新し、robots.txtをテストし、canonicalタグを正しく保ちましょう。