Intro

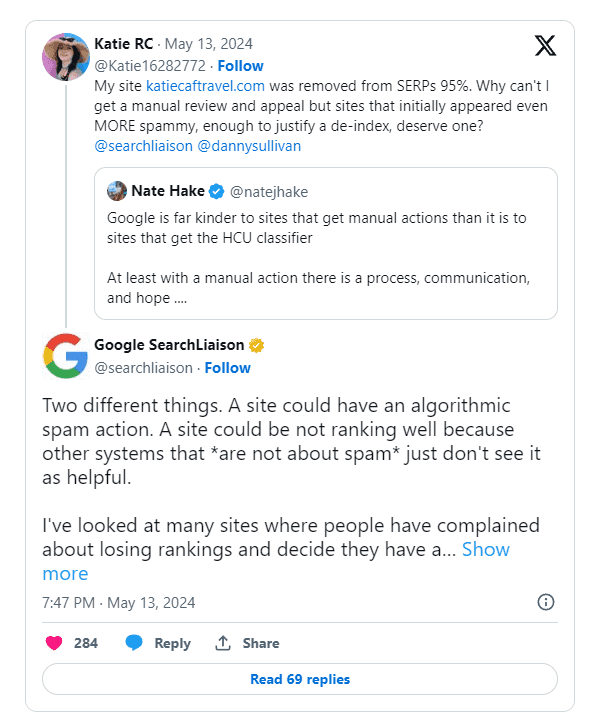

Lors d'un récent échange sur Twitter, Danny Sullivan, chargé de liaison avec Google pour les recherches, a fait la lumière sur les difficultés rencontrées par Google pour assurer la transparence des changements de classement algorithmique et des révisions manuelles. La discussion a débuté lorsqu'un propriétaire de site web s'est plaint d'une perte importante de trafic et de l'impossibilité de demander une révision manuelle.

M. Sullivan a expliqué qu'un site pouvait être affecté par une action de spam algorithmique ou simplement mal classé en raison d'autres facteurs. Il a fait remarquer que de nombreux propriétaires de sites attribuent à tort les baisses de classement à des actions de spam algorithmique, alors que d'autres raisons pourraient être en jeu.

"J'ai examiné de nombreux sites sur lesquels les internautes se plaignaient d'avoir perdu leur classement et pensaient qu'ils faisaient l'objet d'une action algorithmique de spam, mais ce n'était pas le cas.

Défis en matière de transparence et d'intervention manuelle

M. Sullivan a reconnu les avantages potentiels d'une plus grande transparence dans Google Search Console, à l'instar des notifications pour les actions manuelles. Il a toutefois souligné deux défis majeurs :

-

Révéler les indicateurs algorithmiques de spam Cela pourrait permettre à de mauvais acteurs de jouer avec le système.

-

Actions algorithmiques non spécifiques Les actions algorithmiques ne sont pas spécifiques à un site et ne peuvent pas être levées manuellement.

M. Sullivan a exprimé sa sympathie pour la frustration des propriétaires de sites qui ne parviennent pas à déterminer la cause d'une baisse de trafic ou à communiquer avec quelqu'un à ce sujet. Il a également mis en garde contre le désir d'une intervention manuelle pour passer outre les classements automatisés, car cela pourrait ne pas être aussi bénéfique qu'il n'y paraît.

Vous n'avez pas envie de vous dire "Oh, j'aurais aimé avoir une action manuelle, ce serait tellement plus facile". Vous ne voulez vraiment pas que votre site individuel soit porté à l'attention de nos analystes du spam. Premièrement, ce n'est pas comme si les actions manuelles étaient traitées instantanément. Deuxièmement, c'est simplement quelque chose que nous savons à propos d'un site à l'avenir, surtout s'il dit qu'il a changé mais que ce n'est pas vraiment le cas.

Déterminer l'utilité et la fiabilité du contenu

M. Sullivan a évoqué divers systèmes permettant d'évaluer l'utilité, le caractère utile et la fiabilité des contenus et des sites. Il a reconnu que ces systèmes sont imparfaits et que certains sites de grande qualité peuvent ne pas être reconnus comme ils le devraient.

"Certains d'entre eux se classent très bien. Mais ils ont reculé dans des positions suffisamment petites pour que la baisse de trafic soit notable. Ils supposent qu'ils ont des problèmes fondamentaux, mais ce n'est pas le cas - c'est pourquoi nous avons ajouté une section entière à ce sujet dans notre page sur le débogage des baisses de trafic".

La plateforme tout-en-un pour un référencement efficace

Derrière chaque entreprise prospère se cache une solide campagne de référencement. Mais avec d'innombrables outils et techniques d'optimisation parmi lesquels choisir, il peut être difficile de savoir par où commencer. Eh bien, n'ayez crainte, car j'ai ce qu'il vous faut pour vous aider. Voici la plateforme tout-en-un Ranktracker pour un référencement efficace.

Nous avons enfin ouvert l'inscription à Ranktracker de manière totalement gratuite !

Créer un compte gratuitOu connectez-vous en utilisant vos informations d'identification

Il a également évoqué les discussions en cours sur la possibilité de fournir davantage d'indicateurs dans la Search Console pour aider les créateurs à comprendre les performances de leur contenu. Toutefois, il a souligné les difficultés liées au partage de ces informations, sans pour autant permettre aux systèmes d'être manipulés.

Plaidoyer pour les petits éditeurs et le progrès positif

En réponse à une suggestion de Brandon Saltalamacchia, fondateur de RetroDodo, concernant l'examen manuel des "bons" sites et la fourniture de conseils, M. Sullivan a fait part de ses réflexions sur les solutions possibles. Il a mentionné l'exploration d'idées telles que l'auto-déclaration par le biais de données structurées pour les petits éditeurs et l'apprentissage à partir de ces informations pour apporter des changements positifs.

"J'ai quelques idées que j'ai explorées et proposées sur ce que nous pourrions faire avec les petits éditeurs et l'auto-déclaration avec des données structurées, et comment nous pourrions en tirer des leçons et les utiliser de diverses manières. Je vais un peu vite en besogne et je ne promets rien, mais oui, je pense et j'espère que nous pourrons aller de l'avant de manière plus positive.

M. Sullivan a conclu en exprimant son espoir de trouver des moyens d'aller de l'avant de manière positive, même s'il ne pouvait pas faire de promesses ou mettre en œuvre des changements du jour au lendemain.